最近这两周我几乎没怎么睡好,为了搞清楚几个所谓“AI 公链”的底层逻辑,我看代码看得眼睛都要瞎了。说实话,现在的市场环境很浮躁,随便哪个老旧的 L1 给自己套个大模型的外壳,就能喊出 AI 赛道的口号,这种现象让我非常反感。这就像是给一辆老旧的马车装了个特斯拉的中控屏,然后告诉大家这是自动驾驶,不仅荒谬,简直是在侮辱开发者的智商。这种强行嫁接的模式,就是我所谓的“AI-added”——为了蹭热度而做的后天缝合。而最近我在研究 Vanar 的时候,感受到了一种久违的、属于架构层面的清醒,它试图走一条完全不同的路,也就是“AI-first”。

我们得把话摊开来说,现在的区块链基础设施根本支撑不起真正的 AI 商业化。我在以太坊或者 Solana 上尝试部署一个简单的生成式 AI 交互合约时,遇到的最大阻碍不是代码本身,而是链本身对于“计算”这个概念的理解偏差。在传统的 EVM 架构里,所有的计算都被视为同质化的状态转换,转账 1 个 ETH 和验证一个复杂的推理证明,在底层看来除了 Gas 消耗不同,没有任何优先级或处理逻辑上的本质区别。这就是“AI-added”的致命伤。无论你怎么通过 L2 去扩展,无论你怎么优化 Rollup 的打包效率,只要底层的地基是为了金融账本设计的,AI 所需要的高并发、非确定性数据验证和庞大的上下文索引,就永远是这一架构下的“异类”。

这种感觉在使用某些热门竞品时尤为明显。比如我之前深度参与过的某个打着 AI 旗号的 L2 项目,它所谓的 AI 支持,仅仅是提供了一个并不怎么好用的预言机接口,把链下的推理结果回传到链上。这不叫基础设施创新,这叫打补丁。开发者需要的不是一个补丁,而是一个从共识层就开始考虑到 AI 负载特性的环境。这就是我为什么要把 Vanar 单独拎出来写这篇分析的原因。它不是在现有的地基上搭违章建筑,而是试图重新浇筑地基。

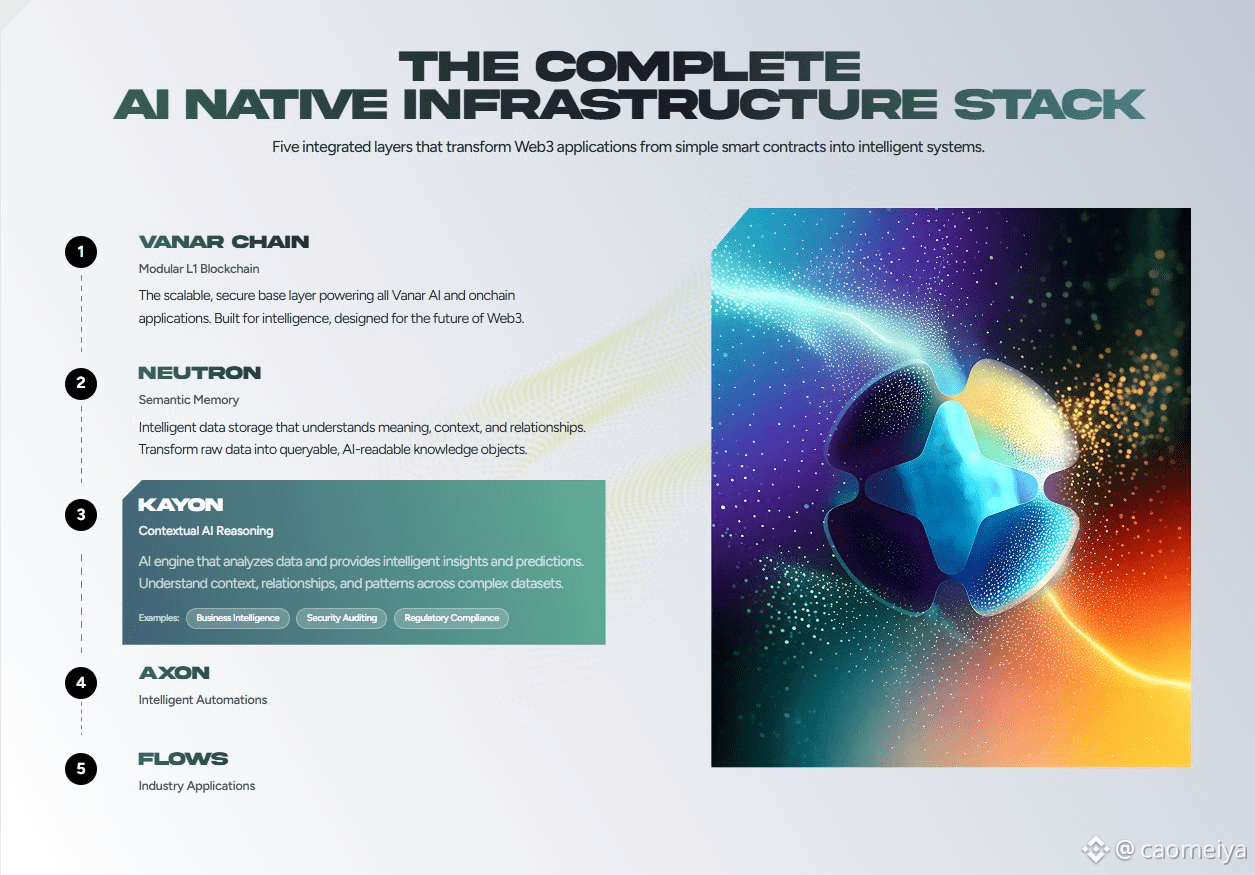

当我第一次打开 Vanar 的文档,尤其是看到它对 Creator Pad 和底层资源的分配逻辑时,我意识到这个团队可能真的懂开发者在痛什么。Vanar 的核心逻辑在于,它不把 AI 仅仅看作是一个“应用”,而是把它看作一种“资产类别”和“交互范式”。在 Vanar 的设计哲学里,AI-first 意味着链的节点结构、存储索引甚至费用模型,都要为 AI 模型的高频调用做原生的适配。这听起来很抽象,但我举个实际的例子你们就明白了。在传统的链上,我如果要做一个由 AI 驱动的动态 NFT,每一次 AI 模型的参数更新都需要走一遍极其昂贵的链上确认流程,这直接导致了成本的不可控。但在 Vanar 的环境里,我发现它似乎在尝试将这种计算过程“内化”,虽然目前测试网阶段偶尔会有吞吐量的波动,甚至我在用 Creator Pad 这种无代码工具时,也遇到过几次前端卡顿,把我的耐心磨得差不多了,但从后端反馈的数据来看,它对于复杂计算指令的响应机制是截然不同的。

这就是我说的原生基因。与其说是公链,不如说 Vanar 更像是一个去中心化的计算调度中心,只不过它刚好拥有区块链的不可篡改特性。这种差异在与 Solana 的对比中显得很有趣。Solana 确实快,它的并行处理能力极强,但 Solana 的快是建立在极高的硬件门槛和对金融高频交易的极致优化上的。如果你在 Solana 上跑大规模的 AI 数据索引,你会发现它的状态膨胀问题会迅速成为瓶颈。Vanar 显然避开了这种硬碰硬的算力堆叠,它更侧重于模块化的灵活性。它允许 AI 项目方在链上构建自己的生态闭环,而不需要去和 DeFi 协议抢占那有限的区块空间。

这就引出了一个很关键的问题:在这个生态里,代币到底扮演什么角色?如果仅仅是作为 Gas,那它的价值捕获能力是有限的。在我深入研究 $VANRY 的经济模型时,我看到了一个试图解决“计算定价”问题的尝试。在 AI-first 的架构下,代币不仅仅是过路费,它是算力资源的“凭证”。当我在 Vanar 链上调用某个生成式工具时,$VANRY 在这里充当了一种动态的调节阀。它平衡了节点验证者的计算成本和用户的使用需求。这和 Render Network 有点像,但 Render 更多是专注于渲染算力的撮合,而 Vanar 想要做的是整个 AI 应用生命周期的全栈支持。从数据上链、模型训练验证到最终的应用分发,它试图用 $VANRY 把这些环节串联起来。

这种设计很大胆,但也伴随着巨大的风险。我在测试过程中发现,目前的生态应用还比较单薄,虽然 Creator Pad 降低了门槛,让很多像我这样懂点代码但不想写前端的人能快速上手,但真正杀手级的 AI 原生应用还没有出现。这其实是整个行业的通病,不仅仅是 Vanar 的问题。但我必须吐槽一下,Creator Pad 的某些 UI 交互逻辑真的很迷,有时候点击部署后的反馈延迟会让我以为浏览器崩了,甚至有个按钮的文案我都看到了错别字,这种细节上的粗糙感确实需要改进。不过反过想,这种粗糙感反而让我觉得真实。如果一个项目的主网还没上线多久,配套工具就完美得像苹果的产品,那我反而会怀疑他们是不是把钱都花在面子工程上了。

回到技术本身,为什么我说 AI-added 是一条死路?因为 AI 的发展速度是指数级的。今天的 GPT-4 可能还需要几秒钟来生成回复,明天的模型可能就是实时的流式输出。现有的区块链架构,无论是扩容方案还是分片技术,都在追赶摩尔定律的尾巴。而 AI-first 的思路是,我不需要在链上跑完整个模型,我只需要在链上验证“计算的有效性”和“数据的真实性”。Vanar 在这方面的尝试非常激进,它试图通过合作和底层优化,让链成为 AI 的信任层,而不是计算层。这非常聪明。它不试图去取代 AWS 或 Google Cloud,而是做这些云服务无法做到的事情——确权和价值流转。

我在对比 Near Protocol 的时候,这种感觉更强烈。Near 的分片技术确实厉害,它的账户模型也非常适合大规模用户进入,但在 AI 垂直领域的深耕上,Near 依然显得有些“通用化”。通用意味着平庸,意味着你需要照顾到 DeFi 的原子性,需要照顾到 GameFi 的低延迟,最后往往是在各个需求之间做妥协。而 Vanar 给我的感觉是,它甚至愿意为了 AI 的优化而牺牲一部分通用性。这种取舍在做产品时是极其宝贵的品质,但在做公链时则是一场豪赌。赌赢了,它就是 Web3 时代的英伟达;赌输了,它就是又一条鬼城链。

让我印象深刻的还有一个点,就是 Vanar 对于 IP 和娱乐产业的切入。这看起来好像和 AI 没什么关系,但实际上关系巨大。AI 最容易落地的场景是什么?不是复杂的金融预测,而是内容生成。Vanar 显然看准了这一点,它拉拢了很多传统 Web2 的巨头入局,这种策略非常务实。我在浏览他们的合作伙伴列表时,看到的不是一堆不知名的加密原生 DAO,而是实打实的商业实体。这意味着什么?意味着未来的vanar可能会承载大量的法币入金转化需求。这不是空气换空气的游戏,而是有真实的外部价值输入的。

当然,我在写这些代码测试的时候,心里也在犯嘀咕。Vanar 的这种架构对于节点的要求到底有多高?文档里语焉不详。如果节点门槛太高,去中心化程度必然受损,这是区块链的“不可能三角”魔咒。目前我看不到它完美解决这个问题的迹象,但至少它没有回避,而是在尝试通过经济激励来平衡。

再来说说那个 Creator Pad,这玩意儿简直是爱恨交织的典型。它的理念非常好,把复杂的智能合约封装成乐高积木,让创作者可以直接发行 AI 驱动的资产。但我前天晚上试着上传一个稍微大一点的数据集作为 NFT 的元数据时,上传速度慢得像回到了拨号上网时代。这可能是 IPFS 节点的同步问题,也可能是 Vanar 自身网关的限流。这种体验如果不优化,很难留住那些被 Web2 丝滑体验惯坏了的用户。技术愿景再宏大,落到实处就是这几秒钟的加载速度。我希望团队能看到这一点,别整天忙着搞宣发,先把这些影响开发者血压的 Bug 修一修。

现在的市场有一种很坏的风气,就是看不起做基础设施的,觉得那是“轮子党”,大家都想去炒作 Meme,去冲土狗。但作为一个技术信仰者,我始终认为,Meme 的繁荣是建立在基础设施足够便宜和好用的基础上的。如果发一个 Meme 的成本高到离谱,那这个游戏就玩不下去。Vanar 这种 AI-first 的基建,实际上是在为下一波应用爆发铺路。它在赌 Web3 的下一个周期不再是金融的自循环,而是内容和智能的大爆发。

我在分析 $VANRY 的 K 线(虽然这篇不谈交易,但数据反映热度)时,能看出市场对它的定位还是很模糊的。很多人还是把它当成一个普通的 L1 在炒。这其实是个机会,也是个误解。当市场还没有意识到“专用基础设施”和“通用基础设施”的估值逻辑差异时,就是认知差存在的时候。AI-first 的链,其价值不应该用 TVL(锁仓量)来衡量,而应该用 Compute Volume(计算量)和 Data Throughput(数据吞吐量)来衡量。这是两套完全不同的估值体系。Vanar 如果能把这套新的叙事讲通,那它的天花板会比现在的价格高出几个数量级。

回过头来看,我们为什么要关心 Vanar 是 AI-first 还是 AI-added?因为这决定了我们是在投资未来,还是在投资过去。以太坊是过去的辉煌,它是燃油车时代的霸主;而像 Vanar 这样的探索者,更像是电动车早期的尝试。它们可能有里程焦虑(生态不足),可能有充电桩覆盖不够(开发者工具不完善),但它们代表了能源利用效率的进化方向。

这几天我反复在想,如果有一天,我们的数字助理、我们的虚拟分身、我们的链上资产,全部都由 AI 自动管理,那么底层的账本需要具备什么样的特性?它必须是智能的,它必须能理解复杂的意图,而不仅仅是执行二进制的代码。Vanar 正在往这个方向靠拢。它试图在链的协议层加入对 AI 数据的语义理解,这在目前看来是非常科幻的,但也是非常性感的。

我写到这里,键盘都要敲出火星子了。其实对于我们这些在这个行业里摸爬滚打的人来说,最怕的不是亏钱,而是失去了对技术演进的敏感度。当你习惯了 EVM 的那套逻辑,你就很难跳出来去思考,也许区块链本来就不应该这么慢,也许 Gas 费本来就不应该由用户来支付,也许智能合约真的可以“智能”。Vanar 给了我一个跳出框架思考的契机。它不仅仅是一个项目,更像是一次对现有区块链架构的暴力拆解和重组。

当然,这一切的前提是 Vanar 能够活过这个残酷的熊市周期(或者说震荡期)。基础设施的建设是枯燥且漫长的,它没有 Meme 币那种一夜暴富的快感。它需要团队耐得住寂寞,去一行一行地优化代码,去一个一个地谈合作伙伴。我看这几天的 GitHub 提交记录,频率还算凑合,至少证明开发人员没跑路,还在干活。对于一个处于早期阶段的项目来说,这就已经是某种程度上的利好了。

说了这么多,其实核心就一句话:别被那些拿着旧地图找新大陆的项目忽悠了。AI 时代的区块链,绝对不是现在的模样。它需要彻底的基因改造,而不是整容手术。Vanar 正在做这个基因改造的手术,虽然现在还在手术台上,伤口还渗着血,缝合线也没拆,甚至医生偶尔还会手抖一下(比如那个该死的上传速度),但我愿意在一个安静的角落,看着这场手术能否成功。因为一旦成功,它创造的生命体,将彻底改变我们与数字世界交互的方式。

我们需要的不是更多的 L1,而是更懂 AI 的 L1。在这个充斥着 copy-paste 代码的圈子里,Vanar 这种试图从底层逻辑上进行变革的尝试,哪怕只有 10% 的成功率,也值得我们投入 100% 的关注。这不仅是为了那个可能的百倍回报,更是为了验证我们对于 Web3 未来的猜想是否正确。毕竟,如果未来真的来了,你总不想手里还紧紧攥着诺基亚吧?

如果你也厌倦了那些换汤不换药的所谓创新,不妨去他们的测试网或者 Creator Pad 上跑一跑,去亲自体验一下那种不仅是速度上的快,而是逻辑上的“顺”。当然,记得多备点耐心,毕竟前沿科技的早期体验,往往都是伴随着 bug 和崩溃的。但这不正是探索的乐趣所在吗?

最后,给各位还在代码堆里挣扎的兄弟们一句劝:看懂了架构,才能看懂价值。别让市场的噪音淹没了你对技术的判断力。在这个变革的前夜,保持清醒,比什么都重要。

对了,如果你想去验证我说的那些槽点和亮点,或者想看看那个让我又爱又恨的 Creator Pad 到底长啥样,自己去挖掘吧。