Dans la convergence actuelle d'une explosion de l'IA et de l'évolution rapide de l'infrastructure Web3, « calcul décentralisé + services cloud d'IA » est devenu un sujet brûlant pour les développeurs et les entreprises. D'Akash à Render, Golem à Bittensor, de nombreux projets ont revendiqué leur part de ce domaine. Pourtant, un nom discrètement sous-estimé avec des fondamentaux solides émerge en coulisses— $FLUX .

Flux n'est pas seulement une plateforme cloud décentralisée ; c'est une fondation AI full-stack qui s'étend sur sa propre blockchain L1, un réseau de calcul mondial, le déploiement et l'hébergement de modèles, et des services d'IA prêts à l'emploi. En d'autres termes, Flux construit un cloud d'IA véritablement utilisable, évolutif et durable pour le monde Web3.

1. Du réseau de calcul à la plateforme AI full-stack

Flux a commencé comme une blockchain L1 haute performance, mettant l'accent sur un consensus Proof-of-Work pour la sécurité et la gouvernance en chaîne. Il a ensuite évolué en un réseau de plus de 16 000 nœuds mondiaux offrant un calcul décentralisé via son FluxOS natif. Contrairement à Akash ou Golem—qui ne louent que du calcul brut—Flux a franchi une étape supplémentaire en lançant FluxINTEL, un moteur d'IA où les développeurs peuvent déployer, exécuter et monétiser leurs modèles sans effort : intégration frontale, appels API, et règlement en chaîne, le tout dans un seul flux.

Pour faire simple : Flux est moins une plateforme de calcul et plus un cloud d'IA décentralisé pour le Web3.

2. Forces techniques fondamentales : Conçu pour l'IA

Preuve de Travail Utile (PoUW)

Le PoW traditionnel brûle des cycles sur des hachages sans signification. Le PoUW de Flux dirige cette puissance de calcul vers de vraies tâches d'entraînement et d'inférence d'IA, sécurisant la chaîne tout en servant des charges de travail d'apprentissage profond authentiques.Support Docker natif

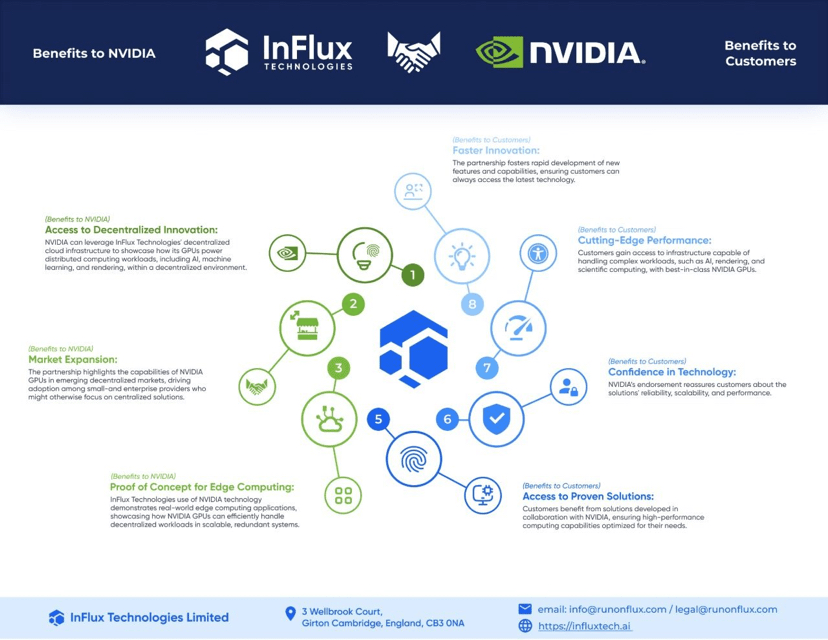

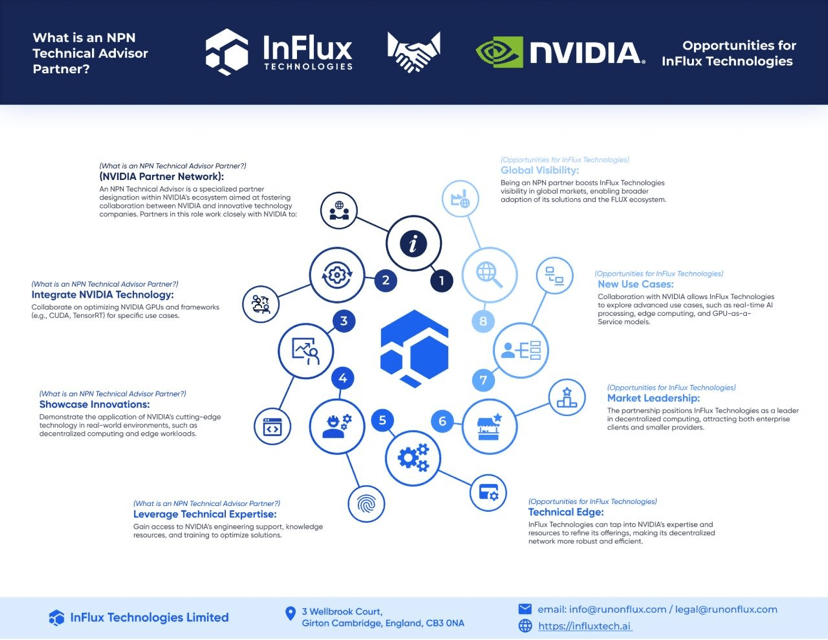

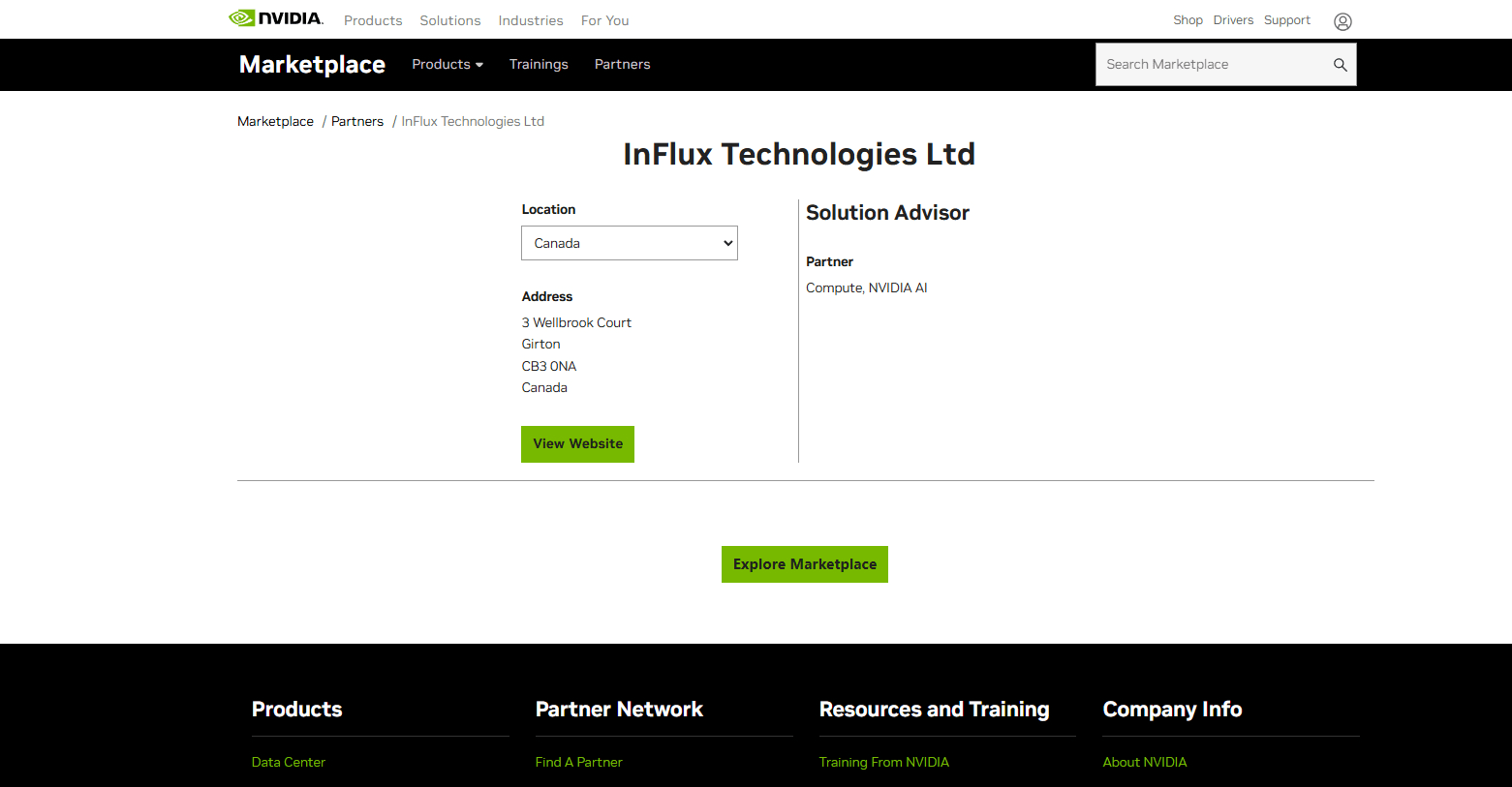

Emballer votre modèle ou service dans un conteneur Docker et le déployer instantanément sur n'importe quel nœud Flux—sans scripts complexes ni langage de configuration sur mesure requis. Cette facilité d'utilisation surpasse les modèles YAML d'Akash et la configuration d'environnement personnalisée de Golem.Nœuds accélérés par GPU

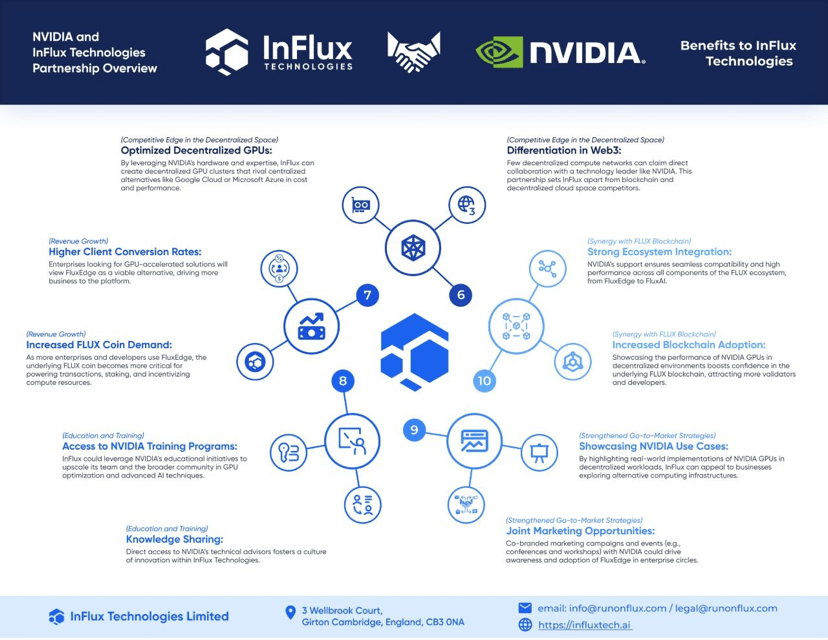

En partenariat avec NVIDIA, Flux intègre des clusters GPU dans son réseau, permettant un entraînement et une inférence accélérés par CUDA qui rivalisent avec les offres centralisées à une fraction du coût.Capacités d'IA de bout en bout

Au-delà de l'entraînement et du déploiement, FluxINTEL fournit des API d'IA prêtes à l'emploi—Q&R intelligent, reconnaissance d'image, analyse de documents, et plus—vous n'avez donc pas à construire chaque couche vous-même.

3. Comment Flux se compare à la concurrence

Akash : Excellent pour la location de calcul bare-metal mais manque d'une couche de service d'IA.

Render : Optimisé pour les studios de rendu mais limité pour les cas d'utilisation de l'IA générale.

Golem : Réseau de calcul flexible mais un écosystème fragmenté avec peu d'outils clés en main.

Bittensor : Communauté novatrice de « mining de modèles », mais manque des outils commerciaux et du soutien qu'offre Flux.

Flux : Fournit le spectre complet—calcul, déploiement, moteur d'IA, paiements en chaîne, et gouvernance—le tout dans un package unifié et convivial pour les développeurs.

4. Écosystème et partenaires d'entreprise

La force croissante de Flux n'est pas seulement technique—elle est soutenue par des partenariats avec des leaders de l'industrie :

NVIDIA : Clusters GPU haute performance pour un entraînement et une inférence de modèles accélérés.

Cloudflare : Tire parti des nœuds d'edge globaux et du stockage R2 pour une intégration transparente du calcul en périphérie et du stockage décentralisé.

IPFS/Filecoin : Stocke les données d'entraînement d'IA et les paramètres de modèle de manière fiable avec plusieurs copies redondantes.

Polygon & Binance Smart Chain : L'interopérabilité multi-chaînes permet aux contrats intelligents sur d'autres chaînes d'accéder sans effort aux services d'IA de Flux.

Google Cloud & AWS (à venir) : Intégration prévue avec des clouds publics majeurs pour mélanger le calcul centralisé et décentralisé dans les environnements d'entreprise.

Du côté des développeurs, le portefeuille Zelcore regroupe la gestion du réseau Flux, la surveillance des nœuds et la gouvernance dans une seule application, tandis que les SDK JavaScript et Python facilitent l'intégration. Les hackathons communautaires et les programmes de subventions incubent continuellement de nouvelles DApps et solutions d'IA sur Flux.

5. Perspectives d'avenir

Court terme (6–12 mois)

Élargir FluxINTEL avec un support AI multi-modal (vidéo, audio, streaming en temps réel)

Déployer des solutions spécifiques à l'industrie : service client intelligent, contrôle qualité industriel, assistance à l'imagerie médicale

Moyen terme (1–2 ans)

Lancer un marché décentralisé d'IA : listing en chaîne, trading, et appel de modèles et datasets

Former des DAOs d'IA où la communauté co-gère les mises à jour des modèles, le balisage des données, et les feuilles de route des fonctionnalités

Long terme (3–5 ans)

Devenir le fournisseur de calcul en périphérie de choix pour les scénarios de métavers, IoT, et conduite autonome

Créer un marché de données d'IA qui combine stockage distribué et incitations tokenisées pour un partage de données sécurisé et efficace

Conclusion

Alors que l'IA et le Web3 convergent vers l'infrastructure Internet de nouvelle génération, Flux se démarque non seulement comme un cloud décentralisé mais comme un écosystème complet, natif de l'IA, propulsé par la blockchain. Il ne fait pas étalage de sa présence comme Render, ne s'appuie pas uniquement sur la recherche comme Bittensor, ou ne loue pas simplement du calcul comme Akash—au lieu de cela, il fusionne discrètement toutes ces capacités en une plateforme unifiée, prête à la production.

Flux a peut-être été un léviathan caché jusqu'à présent, mais son architecture solide, son empreinte de nœuds globale et ses partenariats de premier plan le positionnent pour mener la révolution du cloud d'IA décentralisé. Si vous êtes désireux d'explorer cette frontière, empaquetez un petit modèle dans Docker, déployez-le sur FluxOS, et témoignez de la puissance et de la promesse d'un véritable cloud d'IA décentralisé.