La transición hacia una infraestructura centrada en la IA no es simplemente una actualización tecnológica; es un cambio estructural en cómo se toman las decisiones, se ejecutan las acciones y se distribuye la responsabilidad. A medida que la automatización avanza más allá de la asistencia y hacia la autonomía, la pregunta ya no es si los sistemas pueden actuar de manera independiente, sino si deberían hacerlo—y bajo qué restricciones. Aquí es donde Vanar entra en la discusión, no como otra capa de ejecución, sino como un experimento en la incorporación de inteligencia directamente en el tejido de los sistemas descentralizados. Ese experimento expone una tensión central: cuanto más capaces se vuelven los agentes autónomos, más esenciales son la privacidad, la transparencia y la supervisión humana para su legitimidad.

Los sistemas nativos de IA difieren fundamentalmente de los paradigmas de automatización anteriores. Las blockchain tradicionales procesan entradas discretas y bien definidas: transacciones, saldos, firmas. La infraestructura nativa de IA, en cambio, opera sobre el contexto. Ingiere documentos, intenciones, comportamientos históricos y señales probabilísticas, y luego los transforma en decisiones que pueden alterar estados financieros, resultados de gobernanza o entornos digitales. La privacidad en este entorno ya no se trata de ocultar saldos o anonimizar direcciones; se trata de controlar cómo se accede, interpreta y actúa sobre el significado mismo.

En el corazón de este cambio está el dato semántico. Cuando la información se comprime en representaciones legibles por máquina que preservan la intención y las relaciones, la superficie de riesgo se expande dramáticamente. Un sistema que entiende un acuerdo legal o una obligación financiera también es capaz de malinterpretarlo, generalizarlo en exceso o aplicarlo fuera de su contexto original. La privacidad, en este sentido, es inseparable de la restricción epistémica: limitando no solo quién puede ver los datos, sino hasta dónde se le permite a un agente automatizado razonar con ellos.

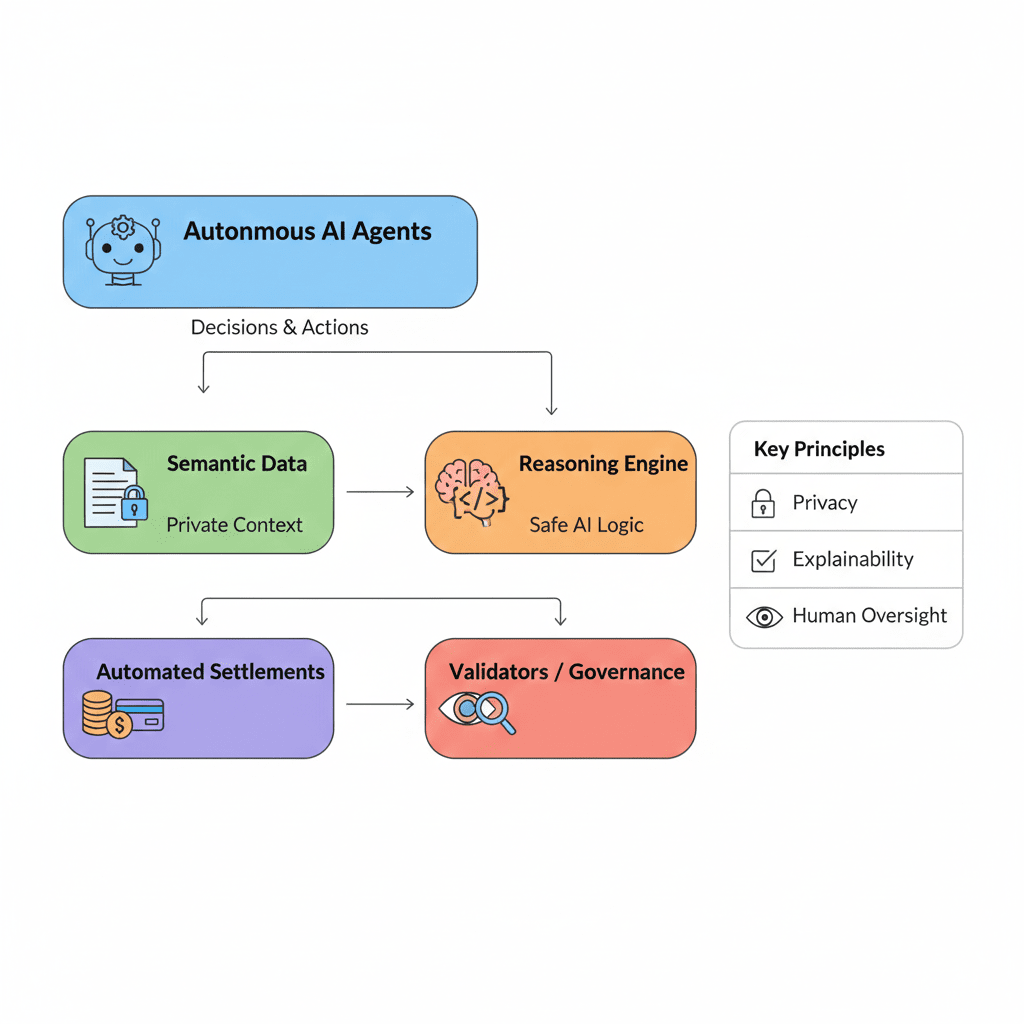

La acción autónoma agrava este riesgo. Una vez que los sistemas de razonamiento están conectados a capas de ejecución, el análisis ya no es teórico. Las decisiones se traducen directamente en pagos, transferencias de activos, ejecución de reglas o reequilibrio económico. En tales entornos, los modos de falla no son abstractos. Una inferencia errónea puede desencadenar consecuencias en cascada a través de sistemas interconectados. Las violaciones de privacidad ya no se limitan a la exposición de datos; se convierten en vectores de manipulación económica, coerción o sesgo sistémico.

Aquí es donde la idea de la automatización 'sin intervención' comienza a desmoronarse. Si bien la IA sobresale en velocidad y reconocimiento de patrones, carece de la conciencia situacional que proviene de la experiencia humana vivida. No puede intuir el impacto social, el daño reputacional o los matices éticos más allá de lo que ha sido explícitamente codificado. Tratar la autonomía como un sustituto de la responsabilidad crea una ilusión peligrosa: que el cumplimiento puede ser automatizado sin juicio, y que la gobernanza puede reducirse a la ejecución de código. En realidad, eliminar a los humanos de la supervisión no elimina el riesgo; lo oscurece.

Las decisiones arquitectónicas dentro del ecosistema destacan claramente esta tensión. Una capa de memoria semántica unificada concentra el contexto intelectual de una manera que es poderosa pero inherentemente sensible. Los motores de razonamiento que traducen el lenguaje natural en lógica accionable introducen ambigüedad interpretativa. Los marcos de automatización que abarcan economías de juego, mundos virtuales y flujos de pago difuminan la frontera entre la interacción digital y la consecuencia económica real. En cada caso, la privacidad no es una característica opcional, sino un requisito estructural, porque el costo del error se escala con la inteligencia del sistema.

La integración del acuerdo económico completa el ciclo. Una vez que los agentes automatizados pueden iniciar y liquidar transferencias de valor de manera autónoma, la opacidad se vuelve inaceptable. En ese punto, el sistema ya no solo está calculando resultados; está participando en una economía. Las economías requieren confianza, y la confianza requiere la capacidad de explicar por qué ocurrió algo, no solo que ocurrió. La velocidad y el rendimiento importan mucho menos que la legibilidad y la responsabilidad.

Aquí es donde la supervisión humana reafirma su importancia, no como un cuello de botella, sino como una fuerza estabilizadora. La supervisión no significa gestionar cada acción automatizada; significa diseñar sistemas que puedan mostrar caminos de razonamiento, señalar anomalías e invitar a la intervención cuando las decisiones superen los umbrales de riesgo predefinidos. Los validadores, participantes de gobernanza y auditores sirven como una capa social que contextualiza el comportamiento de la máquina dentro de marcos éticos y legales más amplios. Sin esta capa, la autonomía deriva hacia el poder no responsable.

Un camino sostenible hacia adelante se basa en algunos principios fundamentales. Primero, la agencia automatizada debe ser explicable por diseño. Cada acción significativa debe dejar un registro rastreable de las entradas, suposiciones y razonamientos que la produjeron, en una forma que los humanos puedan inspeccionar. En segundo lugar, la gobernanza debe ser de múltiples partes interesadas y continua, no reactiva. Los mecanismos de supervisión deben evolucionar junto con la inteligencia que supervisan, en lugar de rezagar. En tercer lugar, la soberanía de los datos debe permanecer con los usuarios e instituciones, asegurando que el contexto se comparta deliberadamente, no se extraiga de manera oportunista.

La implicación más amplia es clara: la inteligencia sin integridad no es progreso. A medida que los sistemas de IA ganan autonomía, el desafío definitorio ya no es la viabilidad técnica, sino la alineación moral e institucional. La privacidad, la transparencia y el juicio humano no son obstáculos para la automatización; son las condiciones que la hacen socialmente viable. En una economía cada vez más moldeada por agentes autónomos, la confianza se convierte en el recurso escaso. Los sistemas que perduran serán aquellos que traten la confianza como infraestructura, no como una idea secundaria.

Por qué las blockchain públicas fallan en la privacidad de la IA por defecto y lo que una nueva arquitectura hace posible

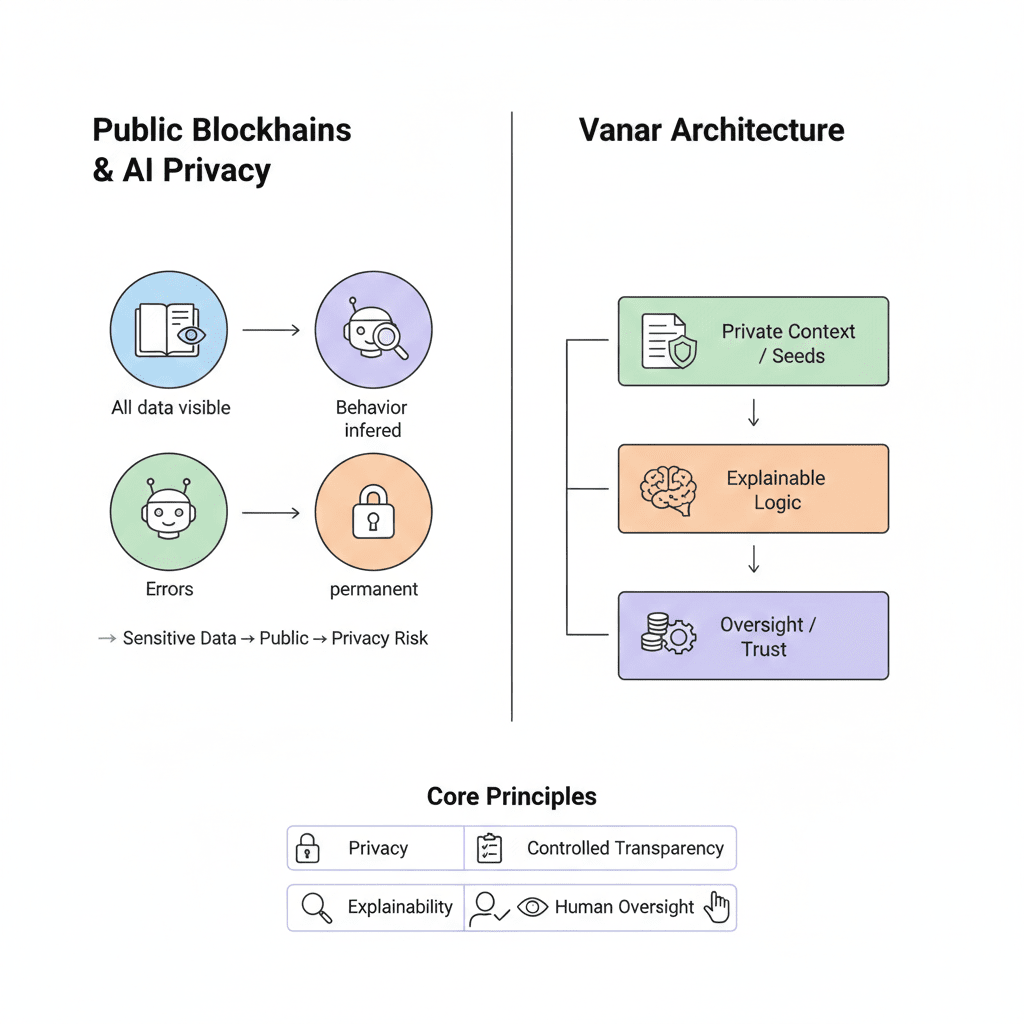

La característica definitoria de las blockchain públicas siempre ha sido la transparencia radical. Cada transacción es observable, cada cambio de estado verificable, y cada interacción preservada indefinidamente. Este modelo funcionó cuando las blockchain eran principalmente libros de contabilidad financieros. Se desmorona en el momento en que la inteligencia artificial se convierte en un participante de primera clase en el sistema.

La IA no solo mueve valor; razona, aprende y actúa sobre contextos sensibles. Consume documentos privados, patrones de comportamiento, lógica interna e inferencias probabilísticas. Cuando tales sistemas se implementan en infraestructura diseñada para visibilidad universal, la falla de privacidad no es un error, es el resultado por defecto. Este no es un problema de herramientas o una característica faltante. Es un desajuste fundamental entre los libros de contabilidad públicos y la automatización inteligente.

La Contradicción de la Privacidad en el Núcleo de las Cadenas Públicas

Las blockchain públicas asumen que la transparencia crea confianza. Los sistemas de IA asumen que la confidencialidad permite la inteligencia. Estas suposiciones colisionan en el momento en que un agente autónomo opera al aire libre.

Un agente de IA que interactúa con contratos inteligentes deja un rastro observable: consultas, elecciones de parámetros, patrones de tiempo y lógica de ejecución. Incluso sin acceder a datos sin procesar, los observadores externos pueden inferir intenciones. Con el tiempo, esto crea un perfil de comportamiento completo del agente mismo. Para las empresas, esto es insostenible. La estrategia se vuelve legible. La ventaja competitiva se evapora. Las operaciones confidenciales se convierten en señales públicas.

Esta exposición no se limita a las empresas. Cualquier sistema de IA que maneje datos personales: financieros, médicos, legales o de comportamiento, corre el riesgo de filtrar información sensible a través de su huella en la cadena. Incluso las entradas encriptadas no pueden enmascarar completamente los patrones de inferencia. En un entorno de ejecución transparente, la privacidad se erosiona a través de la correlación.

Verificabilidad vs. Inteligencia Confidencial

Las cadenas públicas se construyen en torno a la idea de que cualquiera debería poder verificar todo. Los sistemas de IA, en cambio, a menudo requieren visibilidad restringida para funcionar de manera responsable.

Un agente inteligente puede depender de modelos propietarios, conjuntos de datos privados o información regulada. La divulgación completa de entradas no es legalmente permisible ni operacionalmente segura. Los intentos de cerrar esta brecha utilizando técnicas criptográficas introducen fricción. Los sistemas de prueba de conocimiento cero sobresalen en validar afirmaciones estáticas, pero el razonamiento de IA es dinámico, iterativo y probabilístico. Forzar a la inteligencia en marcos de prueba rígidos compromete la usabilidad, la escalabilidad o ambas.

El resultado es un compromiso permanente: o la inteligencia se mantiene lo suficientemente superficial como para ser verificable públicamente, o se vuelve lo suficientemente poderosa como para requerir secreto, pero no se puede confiar en la infraestructura pública. Las cadenas públicas no pueden resolver esta tensión sin abandonar su premisa fundamental.

La Inmutabilidad como un Pasivo

La inmutabilidad asegura la historia, pero los sistemas de IA evolucionan. Los errores de razonamiento tempranos, decisiones sesgadas o datos mal manejados pueden ser registrados permanentemente. En un entorno regulatorio moldeado por leyes de protección de datos y estándares éticos en evolución, el almacenamiento irreversible se convierte en un pasivo.

Si un sistema autónomo procesa datos personales o sensibles incorrectamente, no hay mecanismo para corrección, eliminación o revisión contextual. Esto choca directamente con los marcos de privacidad modernos y expone a los operadores a un riesgo legal y reputacional a largo plazo. Un sistema que aprende con el tiempo no puede coexistir con una infraestructura que congela cada error para siempre.

Un Punto de Partida Diferente para Sistemas Inteligentes

Vanar aborda el problema desde la dirección opuesta. En lugar de adaptar la IA a los libros de contabilidad públicos, adapta la infraestructura a los requisitos de la inteligencia.

La suposición central es simple: la IA significativa requiere contexto controlado. La inteligencia debería operar en entornos donde el significado pueda ser procesado sin exposición, las decisiones pueden ser auditadas sin divulgación completa y las acciones pueden liquidarse sin revelar todo el camino de razonamiento.

Esto lleva a un modelo por capas donde la memoria, el razonamiento y la ejecución están separados por límites de privacidad. Los datos sensibles se procesan localmente y se abstraen en representaciones semánticas. Estas representaciones preservan el significado mientras descartan el contenido sin procesar. El razonamiento opera sobre el contexto en lugar de documentos. La automatización ejecuta resultados mientras expone solo lo que es necesario para la confianza.

Crucialmente, la transparencia se aplica de manera selectiva. El acuerdo económico y las transiciones de estado final permanecen verificables. El proceso cognitivo que condujo allí no necesita ser público para ser responsable. La confianza se deriva de la auditabilidad y la gobernanza, no del voyerismo.

Por Qué Esta Arquitectura Importa

Este cambio desbloquea categorías enteras de actividad impulsada por IA que las cadenas públicas excluyen estructuralmente.

Las empresas pueden implementar sistemas financieros autónomos sin difundir estrategias. Los juegos y mundos virtuales pueden ejecutar economías adaptativas sin exponer el comportamiento de los jugadores a la manipulación. Las industrias reguladas pueden utilizar agentes inteligentes sin violar las leyes de confidencialidad. En cada caso, la privacidad no es un complemento, es la condición previa para la participación.

Más importante aún, esta arquitectura replantea la descentralización en sí misma. La descentralización no requiere visibilidad universal; requiere control distribuido, resultados verificables y gobernanza responsable. La privacidad y la descentralización no son opuestas. Son complementarias cuando la inteligencia entra en el sistema.

De Libros de Contabilidad Públicos a Redes de Inteligencia Privada

El futuro de la blockchain no es una sola hoja de cálculo global donde cada pensamiento sea observable. Es una red de agentes autónomos que operan con visibilidad restringida, produciendo resultados que pueden ser confiables sin exponer su cognición interna.

Las blockchain públicas fallan en la privacidad de la IA por diseño porque equiparan la apertura con la legitimidad. Los sistemas inteligentes exigen una definición más matizada de confianza: una que acepte la confidencialidad, la explicabilidad y la supervisión humana como primitivas fundamentales.

Al comenzar desde las necesidades de la inteligencia en lugar de la ideología de la transparencia, Vanar apunta hacia ese futuro. No una cadena más ruidosa, sino una más silenciosa donde la privacidad habilita la capacidad y la confianza surge de la estructura, no de la exposición.

La Visión de Vanar Chain para Flujos de Trabajo de IA Confidenciales: Construyendo la Capa de Confianza para una Economía Inteligente

La evolución de la inteligencia artificial ya no se define por mejores predicciones o análisis más rápidos. El verdadero punto de inflexión llega cuando los sistemas de IA comienzan a actuar: ejecutando transacciones, haciendo cumplir políticas, reasignando recursos y modelando entornos digitales en tiempo real. En ese momento, una restricción dura se vuelve visible: la inteligencia no puede funcionar de manera responsable sin privacidad. Aquí es donde falla la mayoría de la infraestructura blockchain, no debido a una mala implementación, sino porque sus suposiciones fundamentales son incompatibles con la cognición confidencial.

Los libros de contabilidad públicos fueron diseñados para hacer que el movimiento de valor sea observable y verificable por cualquiera. Sin embargo, los agentes inteligentes operan en contexto sensible: documentos privados, patrones de comportamiento, estrategias internas e inferencias probabilísticas. Transmitir este contexto, o incluso las huellas que deja, socava tanto la confianza como la utilidad. El resultado es un estancamiento estructural: cuanto más autónoma se vuelve la IA, menos adecuados son los sistemas transparentes por defecto para albergarla.

El Requisito No Satisfecho: La Privacidad como Infraestructura Cognitiva

Los sistemas de IA no solo almacenan o transmiten datos; interpretan significados. Extraen conclusiones de relaciones, intenciones e historia. Cuando tales sistemas se ven obligados a operar en entornos donde cada interacción está expuesta, la privacidad falla no a nivel de datos sin procesar, sino a nivel de inferencia. Los observadores pueden reconstruir objetivos, estrategias y debilidades sin acceder nunca a entradas explícitas.

Para las empresas, esto elimina la confidencialidad. Para los individuos, erosiona la agencia. Para los sectores regulados, crea una exposición legal inmediata. Lo más importante es que evita que la IA asuma roles donde la discreción es esencial, roles que los humanos ocupan precisamente porque pueden ser de confianza con información sensible.

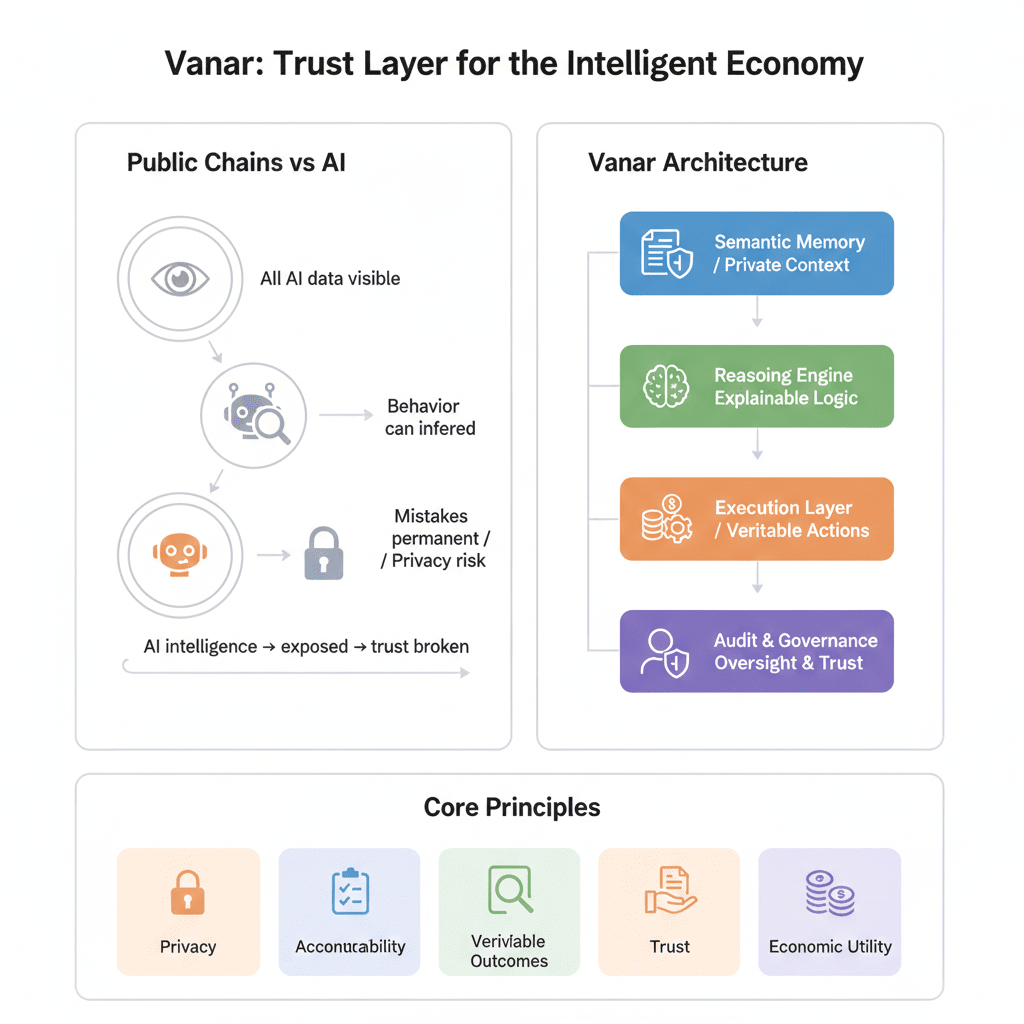

Vanar Chain se construye en torno al reconocimiento de que la inteligencia requiere opacidad selectiva. Su visión replantea blockchain no como una caja de vidrio universal, sino como una capa de coordinación donde los resultados son verificables incluso cuando la cognición permanece privada. Esta distinción es sutil, pero fundamental.

Redefiniendo la Confianza: De la Visibilidad a la Verificabilidad

El modelo tradicional de blockchain equilibra la transparencia con la confianza. En los sistemas inteligentes, esta ecuación ya no se sostiene. La confianza debe derivarse de la corrección, el cumplimiento y la responsabilidad, no de exponer cada paso intermedio.

Los flujos de trabajo de IA confidenciales requieren simultáneamente tres propiedades. Primero, las entradas sensibles deben permanecer protegidas durante el procesamiento. Segundo, el razonamiento debe ser explicable de una manera que apoye la supervisión sin revelar el contexto privado. Tercero, las acciones deben liquidarse de manera verificable para que los resultados económicos y de gobernanza permanezcan auditables.

Esto cambia el papel de la infraestructura. En lugar de hacer cumplir la divulgación universal, debe apoyar la divulgación controlada: revelando lo justo para probar que se siguieron las reglas, sin exponer la información sobre la cual esas reglas operaron.

Un Modelo por Capas para la Inteligencia Confidencial

La respuesta arquitectónica a este desafío es la separación. La memoria, el razonamiento y la ejecución deben existir en capas distintas, cada una con su propio límite de privacidad.

La memoria semántica opera sobre el significado en lugar de contenido sin procesar. Los documentos sensibles se transforman localmente en representaciones contextuales que preservan relaciones e intenciones mientras descartan datos expuestos. Estas representaciones pueden ser razonadas sin reconstruir el material original, permitiendo que la inteligencia funcione sin acceso directo a fuentes confidenciales.

Las capas de razonamiento traducen el contexto en conclusiones. Su responsabilidad no es solo producir respuestas, sino justificarlas. La explicabilidad se vuelve más importante que la observabilidad. El sistema debe ser capaz de mostrar por qué se llegó a una conclusión, incluso si no puede revelar cada entrada que contribuyó a ella.

Las capas de ejecución convierten las conclusiones en acción. En este punto, la privacidad cede ante la responsabilidad. El hecho de que se haya producido una acción, y que haya cumplido con las restricciones de políticas predefinidas, debe ser verificable públicamente. Lo que permanece privado es el camino deliberativo que llevó allí.

Esta es la idea central detrás del diseño de Vanar: la inteligencia ocurre en privado, la responsabilidad se manifiesta en público.

Por Qué Esto Permite una Adopción Real

La mayoría de las discusiones sobre IA en cadena fallan porque ignoran la realidad institucional. Las empresas no operan en público. Los sistemas de salud no pueden exponer el contexto del paciente. Las estrategias financieras pierden valor en el momento en que son observables. Las economías de juego colapsan cuando las mecánicas internas pueden ser revertidas en tiempo real.

Los flujos de trabajo de IA confidenciales desbloquean estos dominios al alinear la infraestructura con cómo funciona realmente la inteligencia en el mundo real. Los agentes pueden analizar balances privados, señales de comportamiento u obligaciones contractuales sin convertirlas en artefactos públicos. Al mismo tiempo, los resultados de ese análisis, pagos, ajustes, liquidaciones, permanecen sujetos a verificación colectiva.

Este equilibrio es lo que permite la autonomía sin caos. Preserva la descentralización mientras reconoce que la discreción no es el enemigo de la confianza, sino su requisito previo.

La Implicación Económica de la Inteligencia Privada

Cuando la actividad inteligente se vuelve privada pero los resultados permanecen verificables, el valor se acumula de manera diferente. Los tokens ya no derivan relevancia de la visibilidad especulativa, sino de su papel en la resolución de decisiones económicas significativas. En este modelo, $VANRY funciona como un instrumento de liquidación para acciones que solo existen porque la inteligencia confidencial las hizo posibles.

Esto replantea la utilidad a un nivel estructural. La red no monetiza la atención o la transparencia; asegura los resultados producidos por la cognición confiable. Cuanto más permite el sistema la toma de decisiones en el mundo real: automatización empresarial, flujos de trabajo regulados, economías digitales adaptativas, más esencial se vuelve su capa de liquidación.

Hacia un Internet Inteligente y de Confianza

El futuro de los sistemas descentralizados no se construirá sobre la exposición radical, sino sobre la contención deliberada. La inteligencia se escala solo cuando está protegida. La autonomía solo se acepta cuando es responsable. La confianza no surge de observar cada paso, sino de saber que los pasos pueden ser examinados cuando importa.

La visión de Vanar Chain posiciona la blockchain como la infraestructura silenciosa debajo de la actividad inteligente: un sistema que permite a los agentes trabajar con la discreción de los humanos y la fiabilidad de las máquinas. En tal economía, la confidencialidad no es una característica que se pueda activar. Es la condición que hace que la inteligencia sea utilizable.

Si la IA va a convertirse en un participante genuino en los sistemas económicos y sociales, requerirá más que computación. Requerirá confianza. Y la confianza, en la era de los agentes autónomos, comienza con la privacidad por diseño.