这两天恰逢周末,阿祖干了一件特别折磨人的事——给自己的硬盘大扫除。移动硬盘、老 NAS、云盘会员,加起来至少塞了十几年的文件:旅游照片、比赛录像、以前写稿的素材,还有一堆我都忘了名字的文件夹。真正想留的东西就那么几样:几份证件扫描件、一些工作文档、少量视频。但为了这点“刚需内容”,我被迫养着一整套“数据养老院”:硬盘要备份,云盘要续费,哪家涨价还得挨宰。

最荒谬的是,这些数据其实半死不活,只要哪天云盘跑路、硬盘坏道,我就一键回到解放前。那一刻我突然意识到,我们嘴上说“数据是新石油”,但大多数数据其实只是被丢在廉价仓库里躺平。真正敢为数据重建基础设施的项目,其实少得可怜。

直到我开始盯 Walrus 的生态,我第一次感受到一种很罕见的信号:不是 PPT 在增长,而是“数据本身”在用脚投票。数据开始自己搬家,而不是项目方在讲故事。

先说一件已经公开的大事。电竞俱乐部 Team Liquid 宣布,把 250TB+ 的历史内容库整体迁移到 Walrus Foundation。比赛录像、幕后花絮、照片和传统媒体资产,一整座“内容雪山”被打包搬进 Walrus,这是目前协议上最大单体数据集的迁移。

内容行业对“迁移”这件事有多敏感,做过内容的都懂。每换一次存储栈,都是一次全身麻醉的大手术,动辄牵扯到权限、格式、团队协作、历史兼容。如果只是想蹭个 Web3 热点,根本没必要动 250TB 这种级别的数据。

Team Liquid 这么干,本质上是在用很现实的逻辑做三件事。它把历史档案统一搬到一个 onchain-compatible 的底层,将来想用 Sui Stack 做二次分发、会员内容、二级授权,不用再迁一次库。它借 Walrus 的数据可用性和容错设计,让这堆“电竞记忆”不再被某家中心化云厂商攥在手里,变成更长久、更可组合的数据资产。它也顺手把“多年来散落在各个系统里的素材”收拢到一个新的内容基建里,让全球团队可以在同一套底座上调取、编排和再创作。

在我看来,这不是简单地“找了个新硬盘”。这更像是 Team Liquid 把自己的内容库,从“死文件仓库”升级成了“随时可以二次创作、打包成产品的资产池”。电竞行业已经给了 Walrus 一个非常清晰的背书:不是说你很酷,而是我愿意把最值钱的东西往你这儿托管。

第二块拼图来自完全不同的一条轨道:身份。Humanity Protocol 这个做去中心化身份的项目,之前一直把 verifiable credentials 放在 IPFS 这类传统去中心化存储上。随着规模扩张,问题就冒出来了:IPFS 在实时更新、选择性撤销和跨链验证上并不友好,而身份系统恰恰要求“能实时查、能精准删、能跨应用调”。

于是 Humanity 做了一个非常重的决策,从 IPFS 迁到 Walrus。目前已经有超过 1000 万条 verifiable credentials 锚定在 Walrus 上,官方目标是把这个数字推到 1 亿级别。这里不仅是数量上的多一位,而是在直接用行动定义“AI 时代的人类身份”应该长什么样:自托管、可验证、可组合,而且不被单一平台绑架。

如果说 Team Liquid 把“谁在打比赛”的记忆搬到 Walrus,那 Humanity 搬的是“谁是真人”的记忆。一个来自娱乐世界,一个来自身份网络,它们对底层存储的要求却高度一致:都需要“可验证,但不被单点控制”的长期存储。

Walrus 给出的答案,是把链当成控制平面,把真实的 TB 级内容交给专门的存储委员会。链上只记录 blob 的 ID、大小、租期、付款方、访问权限等元数据,用 Merkle tree 做集合承诺,把一个轮次的更新压成一个根写进 Sui。链下则由存储委员会负责真正的存储、纠删码编码和自愈恢复,让网络既能横向扩容,又不会逼每个验证者去扛 TB 级数据负担。

这和传统印象里的“区块链存文件”完全不是一回事。传统做法像是把所有箱子都堆到前台,前台迟早会崩溃;Walrus 的做法更像是,链只管钥匙和规矩,后面有一整片真正专业的仓库去负责搬箱子。

第三块拼图,来自已经在存储赛道摸爬滚打多年的专业玩家:Tusky 和 Decrypt。Tusky 自称自己是去中心化存储 Maxi,本质目标就是把用户的文件从 Dropbox、Google Drive 这类 Web2 仓库里救出来,变成真正的链上资产。它选择的底层就是 Walrus,利用 Walrus 的可编程存储,给用户提供公开空间和端到端加密的私密金库,让用户既能用 Web3 的所有权模型,又不必牺牲使用体验。

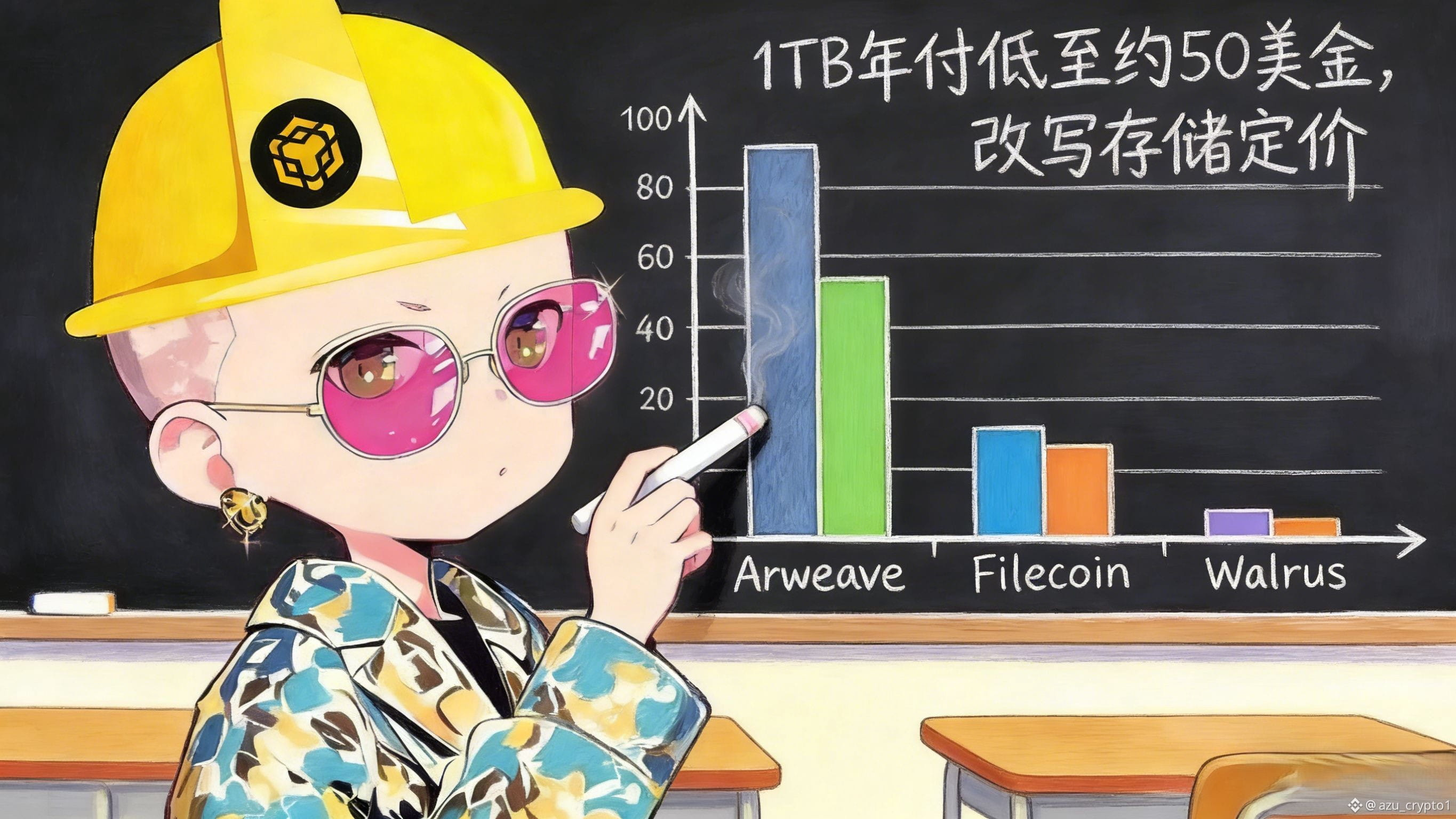

成本曲线是这里最扎眼的一笔。Tusky 在迁移 Walrus 的公告里直接给出了一个数字:1TB 存储,按年付费,最低可以做到每月大约 12 美金。对比一下传统 Web3 存储,有机构估算,Arweave 上 1TB 数据的年成本大概在 3500 美金量级,Filecoin 则在 200–1000 美金之间,而 Walrus 把这件事压到了年均约 50 美金这一档。这已经不是“贵一点点”或者“省一点点”的问题,而是直接改写了去中心化存储的定价锚。

与此同时,Web3 媒体巨头 Decrypt 宣布要把自己的整座内容库搬到 Walrus。以后每一篇文章,都会链接到 Walrus 上对应的存储副本,确保内容在协议层有一份可验证、可长期保存的归档。Unchained 也会把自己的文章、播客和视频档案迁过去,用 Walrus 彻底替代旧的中心化存储栈。

这意味着什么?这意味着媒体行业已经用动作告诉你:Walrus 不只是“某个新协议”,而是我愿意押上品牌档案和历史内容的地方。对这些已经有稳定流量和商业闭环的媒体来说,换存储栈从来不是轻飘飘的技术选择,而是实打实的风险决策。

把 Team Liquid、Humanity、Tusky、Decrypt 这四块拼图放在一起,你会发现一个很有意思的共同点。它们都不是短命的活动页数据,而是迁移成本极高、生命周期极长、真出问题会要命的那种数据。它们来自完全不同的行业:电竞、身份、存储工具、媒体,却在同一个时间段做了同一个动作,从旧世界的存储栈,搬到 Walrus。

在链上世界,我们太习惯用 TVL、活跃地址、交易笔数这种金融指标来衡量一个协议的增长。但对 Walrus 这种专做 blob 存储和数据可用性的协议来说,真正有意义的指标只有一个:有多少本来根本没必要动的大体量数据,愿意自己搬过来。

Team Liquid 的 250TB,是一记很重的锤。Humanity 的 1000 万条身份凭证,是一个新的数量级。Tusky 和 Decrypt 则直接把 Web3 自己的存量内容开始重排。你很难再把 Walrus 当成“还在写白皮书、拉测试网”的那种项目,它已经进入了一个非常朴素却残酷的阶段:有没有人交作业,而且交上来的,是不是大作业。

这种“真实采用曲线”,对短线资金来说一点也不性感。你在行情软件里刷 $WAL 的价格,可能会觉得它不像那种会在牛市里表演烟花的币;你在 X 上搜 Walrus,也不会看到每天冲榜、冲热搜的宣发节奏。它讲的故事,本质上是仓库升级、档案迁移、合规身份基建,对 Degen 来说,这些词都太无聊了。

但如果你把时间轴往 2026 之后拉长一点,问题就会变得不一样。电竞俱乐部、体育联盟、内容平台,会不会越来越在意自己的 IP 资产是不是真的在自己手里?身份协议、KYC/KYB 服务商,会不会需要一个既能实时更新,又能跨链验证、又不会被单点云厂商锁死的存储底座?像 Tusky 这样的存储工具,像 Decrypt 这样的内容平台,会不会持续把自己的用户数据,一点点从 Web2 的“温水池”里往外挪?

如果你相信这些问题的答案大概率是“会”,那你就很难忽视另一个事实:数据正在用脚投票,而 Walrus 已经拿到了第一批真金白银迁移的选票。对我这种偏基础设施、偏长期的观察者来说,Walrus 身上最吸引人的,从来不是它讲了多少好听的故事,而是它现在做的每一个合作,背后都对应着一批“迁一次就不想再迁第二次”的数据。

从这个角度看,它不是在抢流量,也不是在抢叙事,而是在悄悄把“数据搬家公司”的招牌挂起来。谁愿意把 250TB 的内容库、1000 万条身份凭证、整座媒体档案迁到你这儿,谁就已经在用未来的现金流给你投票。

等到有一天,更多行业开始认真问自己一个问题——我的数据到底真正在谁的手里?——你再回头看今天 Walrus 的这条采用曲线,可能就会发现,真正重要的那几次大迁移,早就发生在你刷币价时没太在意的那几周里。